ChatGPTを活用することで、業務の効率化や社員の負担を軽減する結果、コスト削減につながるなど、大きな注目を集めています。

ですが、ChatGPTは米国企業であるOpenAIが提供しており、サーバーも米国にあります。

したがって、プロンプトに個人情報を入力してしまった場合には、個人情報保護法の「外国にある第三者への提供」に該当する可能性があります。

加えて、ChatGPTは入力した情報を学習に用いるため、機密情報を入力してしまった場合にはその機密情報が漏洩してしまうおそれがあります。

すべての生成AIにおいて上記の懸念事項が該当するわけではありませんが、ここでは、ChatGPTにおける情報漏洩のリスクについて、事例も交えて解説していきます。

ChatGPTは情報漏洩の危険がある?危惧される懸念について

自治体や企業などで、ChatGPTを導入し業務に活用する機会が増えていますが、機密情報や個人情報が漏洩しないかと不安になる方も多いでしょう。生成AI全般で言えることですが、ChatGPTは、使い方次第で機密情報や個人情報が流出する可能性があります。

具体的な内容について紹介します。

- 自社の機密情報がChatGPTから漏洩する可能性がある

- 利用者の回答やデバイス情報を取得され個人情報が漏洩する可能性がある

- 誤った情報が生成される場合がある

- 著作権を侵害する恐れがある

自社の機密情報がChatGPTから漏洩する可能性がある

ChatGPTで自社の機密情報を入力すると、その情報が漏洩する可能性があります。

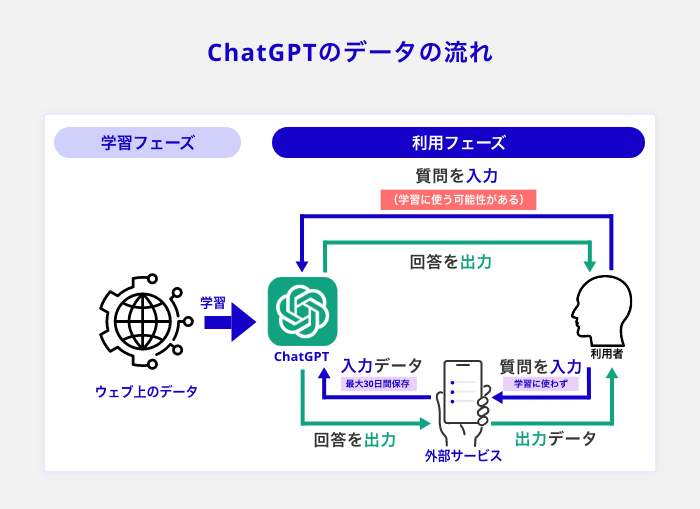

上図では、ChatGPTのデータの流れについて説明しています。

事前学習やファインチューニングを元に、利用者のフィードバックからもデータを集め、強化学習を用いて学習します。強化学習とは機械学習のひとつで、フィードバックの工程で試行錯誤し、コンピューターがデータの価値を最大まで引き上げる学習方法です。

ChatGPTに文章入力をするプロンプトから、フィードバックを受け学習するため、利用者による入力内容が、データとして蓄積されていきます。

データは米国のサーバーに保存されるので、自社の機密情報を入力してしまうと削除や回収が困難です。さらに、そのデータはChatGPTの学習に利用されてしまうと、他人の生成結果に自社の機密情報が表示されてしまう可能性もあります。

実際に、機密情報を社員が入力してしまい、情報が漏洩した企業もありました。情報が流出してしまうと、当然ながら、企業は社会的な信用を失うだけでなく、経済的な損失も発生するでしょう。

チャット形式で、気軽に使えるぶんセキュリティ面の弱さが指摘されているので、利用する際には注意しましょう。

ChatGPTからの情報漏洩を防ぐためには、オプトアウト機能を利用し、ユーザーが入力した内容を学習させないよう設定してください。ChatGPTのオプトアプト機能は、ユーザーが入力したプロンプトやデータを再利用させないよう設定するものです。

オプトアウト機能を利用することで、情報漏洩を防ぐことが可能です。業務にChatGPTを利用する際には、オプトアウト機能を必ず設定しましょう。

利用者の回答やデバイス情報を取得され個人情報が漏洩する可能性がある

ChatGPTは、利用者のデバイス情報やアカウント作成時に入力した情報を収集しているので、個人情報が漏洩する可能性があります。

実際に、10万件のChatGPTのアカウント情報がダークウェブ(通常の方法ではアクセスできない匿名的なWEBサイト)の闇市場で売られるという事例が発生しました。

調査したのは、シンガポールのセキュリティー企業Group-IBで、リアルタイムで闇市場を監視していたところ、ChatGPTのアカウント情報が大量に売られているのを発見しました。インフォスティーラーと呼ばれる、個人情報を抜き取るマルウェアが使用され、売られた情報はフィッシング詐欺に利用される危険があると考えられています。

抜き取られたアカウントは無料登録のものが多く、個人情報のほかに入力された機密情報を入手する目的もあると考え、Group-IBは警鐘を鳴らしています。

参考:日経クロステック「10万件のChatGPTアカウントが闇市場に、どう盗んだのか誰が欲しがるのか」

このように、セキュリティ対策が十分でないと、個人情報が漏洩してしまう可能性があります。

仕事の効率化に便利なため注目されていますが、危険性もあることを理解し、個人情報の漏洩につながらないための行動が必要です。

なお、ChatGPTの利用を禁止していた国もあります。イタリアのデータ保護当局は、ChatGPTの利用を一時的に禁止し、Open AI社に個人情報の流出に対する改善を求めました。

改善を求めた経緯は、ChatGPTで行われた会話の記録や支払い情報が漏洩したと、外部からの声で判明しデータ保護当局が調査しました。その結果、収集している内容を利用者に通知しておらず、アクセスする際の年齢を確認するシステムがなかったことが判明しました。

イタリアがChatGPTの使用を禁止した後、欧州で規制検討の動きが広がり、フランスやドイツ、アイルランドが規制を設けるか検討しています。個人情報の漏洩の懸念があるため、ChatGPTの利用を規制している国もあるのが現状です。

導入する際は最新の注意を払い、セキュリティ対策を怠らないようにしましょう。

参考:NHK「ChatGPT 各国で規制検討の動き 個人情報保護などの懸念から」

誤った情報が生成される場合がある

ChatGPTが生成した文章は、必ずしも正確とは限らないので注意が必要です。

ChatGPTは、ビックデータの中から最適な回答を選びますが、ビックデータ自体の精度や情報源が間違っている場合もあり注意が必要です。また、ChatGPTは強化学習を用いて利用者のフィードバックから学ぶこともできるため、利用者のフィードバックが間違っていると誤った学習をしてしまう可能性もあります。

実際にアメリカの企業で、ChatGPTに100記事分の文章を作成させたところ、約8割の記事で誤った情報を含んでいたという発表がありました。

このことから、ChatGPTで生成される文章は、必ずしも正確とは限らないことがわかります。

参考:読売新聞「「即答」ChatGPTの利用急拡大、ただし過信は禁物…教育現場「正確さに懸念」」

ChatGPTのAIは、情報の正確性を判断できないので、調べた情報は一度社内で確認し使用しましょう。二度手間になりますが、誤った情報で顧客を混乱させないためにも、情報の確認が必要不可欠です。

著作権を侵害する恐れがある

ChatGPTで作成する文章や作品は、著作権を侵害してしまう可能性があります。

ChatGPTが作成するものは、ネットや書籍、論文、雑誌、ニュース記事から情報を収集しています。ネットで公開されている著作物を、許可なく学習に使用している恐れがあるので、作成された文章をそのまま使用する際には注意が必要です。

ChatGPTは、ネット上の文章などを大量に読み込み、利用者が入力したプロンプトに沿って文章を作成します。すでに世の中で公開された記事に似た文章を作成する恐れがあり、アメリカで懸念が広がっています。

アメリカの多くのメディアが属する非営利団体「ニュースメディア・アライアンス」は、AIが報道機関のコンテンツを無断で使用することは知的財産権の侵害だとして、AI運営企業に対して声明を発表しました。。ChatGPTで作成された文章が、著作権を侵害していないか、利用方針に迷う企業も増えているのが現状です。

参考:読売新聞「作家そっくりの作風、チャットGPTが「作品」…著作権の保護曖昧」

ChatGPTで生成された文章は、WEB上の他コンテンツとの重複をチェックできるツールなども利用し、著作権を侵害していないか確認しながら利用できるといいでしょう。

コピペチェッカーなどのツールで、類似のコンテンツがないか調べることができるので、文章の生成後は必ず確認をしましょう。

生成AIの全社導入はすでに約6割に拡大!生成AIの利用実態調査レポート〜2024年12月版〜

2022年、Chat GPTが一般リリースして2年が経ち、生成AIの業務における活用レベルや組織における利用率は確実に向上してきています。

組織としての生成AIの利用が本格化し、これまで以上に成功事例を聞くようになった今、企業の生成AI活用はどう変化しているのでしょうか。

本レポートは2023年4月から継続的に実施しており、5回目となる調査レポートです。262社310人を対象におこなった最新の「生成AIの利用実態調査」を大公開しているため、ぜひご参考にください。

- 企業全体での活用からRAG(データ連携)の取り組み状況

- 社員がどの程度生成AIを活用しているのか、その実態

- さらに注目が集まる「AIエージェント」に関する関心や活用状況 など

ChatGPTの利用でOpenAI社が自動的に取得する情報

ChatGPTの利用による機密情報の漏洩を防ぐには、サービスの利用によりどのような情報が自動的に取得されるのか知っておく必要があります。

ChatGPTの提供元であるOpenAI社のプライバシーポリシーには、「お客様の本サービス利用により当社が自動的に受領する個人情報」として明記されています。

”お客様が本サービスについて訪問し、利用し、やりとりする場合、当社はお客様の訪問、利用、又はやりとりに関する以下の情報(以下、「技術情報」といいます。)を受け取ります。”

引用:『プライバシーポリシー』OpenAI社(2023年11月14日)

ログデータ

ユーザーがChatGPTを利用するたびにデバイスやブラウザが発する情報を、ログデータといいます。ログデータには、利用者のインターネットプロトコルアドレス、ブラウザの種類及び設定が含まれ、ChatGPTを利用した日時や、やり取りの内容が履歴として把握されます。

利用データ

ユーザーが閲覧または関与したコンテンツの種類や利用に際しとった行動、いつどこからアクセスしたか、使用したデバイスやコンピューター接続の方法など、利用に関するあらゆる情報を取得する場合があるとしています。

デバイス情報

デバイス、オペレーティングシステム、デバイス識別子及びブラウザの名称が自動的に取得されます。収集される情報は、デバイスの種類や設定により異なるケースもあります。

クッキー

クッキーとは、Webサイトから利用者のブラウザに送信される情報の小片のことです。利用者がChatGPTを利用する際に生じるクッキーは、サービス向上のための情報として利用されます。クッキーの受け入れはブラウザ上で拒否もできますが、拒否することによりサービスが正常に動作しないといった不具合が生じる場合もあります。

分析結果

ユーザーがサービスをどのように利用しているかを分析するために、上記の情報を使用することがあります。分析結果は顧客体験の向上を目的として利用されます。

情報漏洩やサイバー攻撃に利用された事例

続いて、ChatGPTの利用が情報漏洩やサイバー攻撃に繋がった事例を紹介します。

- サムスンはChatGPTに機密情報を入力し情報が漏洩

- フェイクニュースを作成

- ChatGPTでマルウェアを作成

サムスン電子はChatGPTに機密情報を入力し情報が漏洩

韓国の企業サムスン電子では、社員が機密情報をChatGPTに入力してしまい、情報が漏洩してしまいました。設備情報や会議内容が、ChatGPTを導入してわずか20日の間に漏洩しています。

導入してすぐ情報漏洩してしまったため、サムスンは緊急措置を行いプロンプトの容量を制限しています。

ChatGPTは、オプトアウト設定をしないと入力内容が残ってしまうので、機密情報を扱う際は細心の注意が必要です。ChatGPTはオプトアウト機能で、ユーザーが入力した質問やデータを残さないように設定できます。

自社の情報を漏洩させないためにも、オプトアウト機能を利用し、トラブルを防止してください。

参考:Forbes JAPAN「サムスン、ChatGPTの社内使用禁止 機密コードの流出受け」

フェイクニュースを作成

ChatGPTは、本物のニュースと見分けがつかないフェイクニュースを、作成できてしまう恐れがあります。

中国では、「杭州市が自動車の通行制限を3月1日に撤廃する」という情報が、浙江省の政府系放送局のSNSアカウントで発信されました。話題になりましたが、浙江省は発信内容を否定し、ChatGPTで作られたフェイクニュースだと判明しました。

フェイクニュースを作成した方は、ChatGPTの性能を試すために架空の記事を作成しました。しかし記事の完成度が高く、多くの住民がフェイクニュースだとは知らずに、中国政府が対応に追われるほど拡散されてしまいました。

ChatGPTは本物と誤解してしまうほど、精巧な記事を作成してしまうので、ネットで公開する際も注意が必要です。

参考:東洋経済オンライン「中国「chatGPT」偽ニュース拡散で揺れる政権対応」

ChatGPTでマルウェアを作成

ChatGPTは、悪質なプロンプトには答えない機能がついていますが、入力するプロンプトによって悪質なマルウェアを作成できてしまいます。

2023年4月上旬に、アメリカの企業であるForcepointの研究者が、マルウェアを作成しました。

ChatGPTは悪用を防ぐために、悪質と判断できるプロンプトは、入力しても拒否する機能が付いています。しかし、アメリカの研究者はセキュリティをかいくぐり、マルウェアを作成することに成功しました。

研究者は、ChatGPTでコードを作成する際、マルウェアの機能ごとにプロンプトで依頼し生成しました。機能ごとに作成することで、ChatGPTは悪質なマルウェアと気づかずコードを作成してしまい、マルウェアを作成できてしまいました。

入力する質問によっては、悪質と判断されずChatGPTは回答してしまいます。ChatGPTを利用することで、マルウェアを短時間で作成できてしまうため、サイバー犯罪が増えるのではと懸念が高まっています。

参考:日経XTECH「高度な検出不能マルウエアを数時間で生成、研究者はChatGPTをどうだましたのか」

ChatGPTで機密情報を漏洩しないためのセキュリティ対策

続いて、機密情報の漏洩を防ぐためのセキュリティ対策について見ていきましょう。

なお、「フリーWi-fiからChat GPTを利用しない」など、一般的に企業で守られている事項については、割愛します。

- ChatGPTを利用する際のルールを社内で決める

- 利用に際した社員教育の実施

- ChatGPTのセキュリティリスクを減らせるサービスを利用する

- 会話を学習させないモードを利用する

- ChatGPT Enterpriseプランを利用する

ChatGPTを利用する際のルールを社内で決める

ChatGPTを自社業務に導入する際、利用ルールを社内で決めておきましょう。

具体的には、「著作権を侵害していないか確認してから文章を利用する」というように、どのような場面で・誰が確認作業をするのかを決めるべきです。

また、入力するプロンプトに関しても、社内ガイドラインを制定するなどし、NG例や留意点を定めておくと良いでしょう。導入前に決めておくことで、社員もスムーズにChatGPTの使用を開始することができます。

情報漏洩を事前に防ぐためにも、機密情報や個人を特定できる文章の入力を禁止し、安全にChatGPTを利用できるようにしてください。

ただし、個人情報や機密情報が越境してしまうことなく、データ処理を国内で完結させられる生成AIも登場してきています。

コンプライアンスやセキュリティを遵守しながら、生成AIを活用したい日本企業においては、ぜひ利用を検討してみてください。

参考:「「exaBase 生成AI」 データ処理を国内で完結 〜日本企業向けのセキュリティ、データコンプライアンス対応をさらに強化〜」(株式会社エクサウィザーズ)

利用に際した社員教育の実施

ChatGPTをはじめとした生成AIを業務利用するのであれば、利用に際した社員教育を実施する必要があります。ルールの周知はもちろん、最新の情報漏洩事案の共有などにより、生成AIの利用はリスクをともなうことを十分に理解してもらわなくてはなりません。

あわせて、個人情報保護法や著作権法についての理解を促し、意識を高めていく取り組みも欠かせません。軽率な利用によるトラブルが発生しないように努めましょう。

ChatGPTのセキュリティリスクを減らせるサービスを利用する

セキュリティ対策には、企業向けのChatGPTを導入するのも有効です。

上記説明したような社内ルールを策定することで、ある程度の対策はできますが、十分ではありません。情報漏洩のリスクを最小限にするためにも、セキュリティ対策がされている「企業向けのChatGPT」を導入するのがおすすめです。

企業向けの ChatGPTでは、以下の機能が備わっているものがあります。

- プロンプトに対する禁止ワードの設定

- 社内の利用状況をモニタリングする機能

- セキュリティ面のサポート

企業向けのChatGPTを使用することで、社内で決めたルールを管理でき情報漏洩のリスクも減らせます。

会話を学習させないモードを利用する

ChatGPTには、会話を学習させないモードを選択できる機能があります。オプトアウト機能というもので、ChatGPTでは「Chat History & Training」という機能がこれにあたります。この機能をオフにすることで、ユーザーとChatGPTのやり取りが機械学習に使用されることがなくなり、情報漏洩のリスクが低減できるのです。

業務利用する際には情報漏洩防止の観点から、オフにして使用することをルール化するとよいでしょう。

※日本語版での設定方法

- ChatGPT上のユーザーアイコンをクリック

- 設定をクリック

- データ-コントロールをクリック

- すべての人のためにモデルを改善するをオフにする

ChatGPT Enterpriseプランを利用する

ChatGPT Enterpriseは、法人向けのプランであり情報漏洩リスク低減に効果を発揮します。同プランには企業利用を見越して、使用状況の管理・分析ができるダッシュボードが整備されている点が特徴です。

また、ユーザーが入力したプロンプトやデータは、機械学習に利用されず、送信したデータも暗号化される仕組みになっています。

ただ導入に際してはコストがかかるため、業務利用により効率化できる範囲を見極め、費用対効果を検証する必要があるでしょう。

個人情報保護委員会による注意喚起

生成AIの発展は目覚ましく、利用に際してのルール作りが後手に回っている現状があります。各省庁や企業もガイドラインを策定し対策を行っている中、個人情報保護員会は、生成AIを利用する事業者と、提供元であるOpenAi社に対し注意喚起を行い話題となりました。

今後、法整備も進む中で、生成AI利用による情報漏洩に対し厳しい目が向けられることが予想されます。

事業者に向けた注意喚起

事業者に向けた注意喚起としては、生成AIに個人情報を含むプロンプトを入力する場合は、その利用目的の範囲内であることを確認するように示唆しています。

”個人情報取扱事業者が生成 AI サービスに個人情報を含むプロンプトを入力する場合には、特定された当該個人情報の利用目的を達成するために必要な範囲内であることを十分に確認すること。”

引用:『生成 AI サービスの利用に関する注意喚起等』個人情報保護委員会 2023年6月5日

OpenAI社に向けた注意喚起

個人情報保護委員会は事業者向けの注意喚起と同時に、ChatGPTの提供元であるOpenAI社にも注意喚起を行いました。個人情報の扱いについて、本人の同意を得ることなく収集することを明確に禁じています。

※要配慮個人情報とは、本人の人種、信条、社会的身分、病歴、犯罪の経歴、犯罪により害を被った事実その他本人に対する不当な差別、偏見その他の不利益が生じないようにその取扱いに特に配慮を要するものとして政令で定める記述等が含まれる個人情報。

引用:「個人情報保護法 第二条3項」

ChatGPTの情報漏洩やセキュリティに関するQ&A

そのほかに、よくある質問への回答をまとめました。こちらも最後に見ておきましょう。

- ChatGPTを利用したいが情報漏洩の不安がある

- 社内でChatGPTの利用ルールを決めても社員に浸透するのか不安がある

- ChatGPTのセキュリティを強化したいがやり方が分からない

Q.ChatGPTを利用したいが情報漏洩の不安がある

第三者に、ChatGPTのデータを抜き取られてしまう可能性もあるため、機密情報や個人を特定できる質問は避けてください。

ChatGPTは、利用者が入力したデータを蓄積していくので、不正アクセスがあった場合データを抜き取られる可能性が高いです。不正アクセスがなくても、利用者が入力した内容をChatGPTが第三者の回答に使用してしまうリスクもあります。

情報が漏洩し、社内で対応に追われてしまう事例も出ているので、リスクを理解し対策を考えましょう。

社内で、ChatGPTを利用するガイドラインを作成したり、機密情報を扱う業務には使用しないなど、ChatGPTの導入範囲を決めておくと安心です。また、セキュリティ対策をするなら、企業向けのChatGPTを使用しリスクを防ぐためのサポートを受けるのがおすすめです。

企業向けChatGPTの中には、ユーザーアカウントや利用者のログを管理でき不正アクセスを防げるものもあります。情報漏洩のリスクを回避するためにも、セキュリティがしっかりしている企業向けのChatGPTの利用を検討してみてください。

ChatGPTは、業務を効率化できる便利なツールですが、利用には十分に注意し導入を考えると良いでしょう。

Q.社内でChatGPTの利用ルールを決めても社員に浸透するのか不安がある

ChatGPTを安全に使用するために、社員の利用をモニタリングできる企業向けのChatGPTの導入がおすすめです。

規模が大きい企業であれば、社員の動きをひとりひとり確認するのは難しいです。ChatGPTを利用するルールを浸透させるためにも、利用状況を管理できる企業向けのChatGPTを導入すると、管理が簡単になります。

企業向けのChatGPTの中には、利用者のログを確認できるものや、禁止ワードの設定ができます。管理の手間を省くためにも、企業向けのChatGPTを取り入れるのがおすすめです。

Q.ChatGPTのセキュリティを強化したいがやり方が分からない

セキュリティを強化するためには、ChatGPTの運用をフォローしてくれるサービスを利用すると、すぐにChatGPTを導入することが可能です。

セキュリティ強化には、さまざまな方法がありますが、知見がなければ難しく感じる方も多いでしょう。時間や人件費をかけるより、ChatGPTの運用をサポートしてくれるサービスを利用すると、正しくセキュリティ対策ができます。

企業向けのサービスを利用することで、セキュリティ面に不安がある企業も安心してChatGPTを使用できるでしょう。ChatGPTを安全に利用するための人材の育成や新たに社員を採用する必要がないので、コストも抑えることも可能です。

機密情報の漏洩に最大限注意しながら業務効率化を図ろう

本記事では、業務で使用する文章やプログラミングのコードを作成できたりと、ChatGPTは便利なツールですが、情報漏洩のリスクがあることを紹介しました。社外に出してはいけない機密情報や、個人が特定できる文章は入力しないように注意してください。

ChatGPTに蓄積されたデータを守るためにも、導入時にはセキュリティ対策を考えることが重要です。

しかし、規模が大きい企業であれば、社員がChatGPTをどのように利用しているのか把握しづらいのが現状です。セキュリティを強化するためにも、ユーザーログや利用状況を管理できる企業向けのChatGPTを使用し、社内の状況を把握できるよう対策しましょう。

これらを踏まえ、ChatGPTは便利な反面リスクもあると理解し、対策を考えながら導入してください。